24. Oktober 2019

Das Internet – unendliche Weiten. Nie zuvor in der Menschheitsgeschichte hat sich eine Technologie so rasant verbreitet. Und nichts hat die Art, wie wir kommunizieren, daten und einkaufen sowie uns entspannen, unterhalten und informieren so fundamental verändert wie das World Wide Web. Was der Kalte Krieg mit der Entstehung des Internets zu tun hat, warum man es nicht einfach ausknipsen kann und wie sich der Schutz vernetzter Rechner vor Viren und Hackern entwickelt hat, das erzählen wir in unserer kurzen Geschichte des Internets.

Der 4. Oktober 1957 ist ein großer Tag für die Sowjetunion: Vom Weltraumbahnhof Baikonur im südlichen Kasachstan schießen die Ingenieure der UdSSR den ersten künstlichen Erdsatelliten ins All. Der kugelförmige Sputnik mit seinen vier Antennen ist ein großer Wurf für die Menschheit – und ein überraschender Wirkungstreffer im Wettstreit der Systeme. Der technologische Vorsprung der Sowjets trifft nicht nur empfindlich den Stolz der USA, er sorgt im Pentagon außerdem für enorme Nervosität: Können uns die Russen nun mit Interkontinentalraketen attackieren? Was, wenn dabei auch unsere Nachrichtensysteme lahmgelegt werden? Keine völlig unberechtigte Sorge. Denn seit Anbeginn des Fernmeldewesens erreichen Informationen ihren Empfänger auf einem fixen Weg: Ob Rauchzeichen, Brieftaube, Pony-Express, Telegrafie oder Telefonleitung – die Nachricht geht immer linear von A über B nach Z. Holt der Habicht die Brieftaube, wird der Ponyreiter abgefangen, werden Telegrafenleitung oder Telefonkabel gekappt, erreicht die Nachricht nicht mehr ihr Ziel. Die Lösung dieses Problems: ein System, in dem alle Computer mit anderen verbunden sind, wodurch Nachrichten auf unterschiedlichen Wegen an ihr Ziel gelangen und das Gesamtsystem weniger leicht gestört werden kann.

Digitale Pakete aus Nullen und Einsen: Die Gründung der ARPA

Um diese Überlegungen in die Tat umzusetzen, wird am 7. Februar 1958 die Advanced Research Projects Agency (ARPA) ins Leben gerufen. Schon bald nach der Gründung beginnen die Forscher der ARPA, Pakete zu packen – und zwar Pakete aus Nullen und Einsen. Die Daten, die übermittelt werden sollen, werden in kleine Blöcke, die Pakete, zerlegt. Jedes Paket wird mit einer Absender- und Empfängeradresse und einer Sequenznummer versehen. Das Kommunikationssystem sendet die einzelnen Pakete dann an den Empfänger, wo sie anhand der Sequenznummer wieder in der richtigen Reihenfolge zusammengesetzt werden. Gehen bei diesem Vorgang Pakete verloren, sendet der Empfänger eine Anfrage, um die verlorenen Pakete erneut zu erhalten. Das Besondere daran: Die Pakete können durchaus andere Wege durch das Netzwerk nehmen. Anders als bei einer Telefonleitung mit einer gleichbleibenden Bandbreite kann das zwar zu Verzögerungen führen. Doch dafür wird das Netzwerk effizienter genutzt, die Schnittstellen werden weniger stark belastet, und die Nachrichten erreichen auch dann den Empfänger, wenn ein einzelner Kanal blockiert ist oder lahmgelegt wird.

Diese Idee eines dezentralen Computernetzwerks, in dem die Daten in Paketen verschickt werden, wird Ende der 1960er-Jahre erstmals umgesetzt. Am 29. Oktober 1969 werden die Rechner der University of California in Los Angeles und des Stanford Research Institute in Menlo Park bei San Francisco über eine 50-Kilobit-Datenleitung miteinander verbunden. Die welterste Internetbotschaft, die über das Netzwerk ausgetauscht wird, besteht aus zwei Buchstaben und lautet „lo“. Wenige Wochen später kommen die Großrechner der University of California in Santa Barbara und der University of Utah als weitere Netzwerkknoten zum sogenannten ARPANET hinzu.

Die erste E-Mail und die „Telefonauskunft“ für das Internet

1971 schickt der Informatiker Ray Tomlinson den ersten elektronischen Brief durch das Netz. Um den Namen des Benutzers und den des Rechners, der die Nachricht versendet, eindeutig unterscheiden zu können, wählt Tomlinson das @-Zeichen und fügt dieses dazwischen ein, da es in der Schriftsprache nicht verwendet wird. Damit wird er zum Erfinder der E-Mail.

Noch steckt aber nicht nur die digitale Kommunikation zwischen Menschen, sondern auch die zwischen unterschiedlichen Netzwerken in den Kinderschuhen. Die ARPA-Wissenschaftler Vint Cerf und Bob Kahn finden 1973 eine Lösung, um Netze miteinander zu verbinden, die auf unterschiedlichen Technologien beruhen: Das Transmission Control Protocol und das Internet Protocol, kurz TCP und IP, erlauben zum Beispiel den Austausch zwischen Funk- und Kabelnetzen. Zum TCP/IP-Protokoll weiterentwickelt, wird es zum Standard für den Datenaustausch im Internet.

© dpaDer Vater des World Wide Web: Tim Berners-Lee.

Im Jahr 1982 sind bereits 88 Institutionen mit dem ARPANET verbunden. 1983 beginnt der Informatiker Paul Mockapetris mit der Entwicklung des Domain Name System, kurz DNS – und erfindet damit die Telefonauskunft für das Internet. Anstatt sich die Zahlenkolonne der IP-Adresse einzubläuen, genügt es nun, einen Domain-Namen wie „beispielsweise.org“ zu kennen, um vom DNS mit der Adresse des richtigen Rechners verbunden zu werden. Sechs Jahre später legt Tim Berners-Lee die Grundsteine für das World Wide Web, wie wir es heute kennen.

Winds of change: Tim Berners-Lee und das World Wide Web

Eigentlich will der britische Physiker am Forschungszentrum CERN bei Genf nur ein System zum besseren Informationsaustausch für Wissenschaftler und Universitäten entwickeln. Dazu ersinnt der Forscher die nötigen Komponenten eines solchen Systems: Der erste Baustein ist eine einheitliche Sprache, das HTML, durch die elektronische Dokumente mit Texten, Bildern und Hyperlinks strukturiert werden können. Der zweite Baustein ist die URL, eine Webadresse, die für jede Webseite einzigartig ist und die über Links aufgerufen werden kann. Hinzu kommt ein Protokoll, das die Übermittlung der Informationen im Netz regelt: das Hypertext Transfer Protocol, kurz HTTP. Gespeichert werden die Webseiten auf einem Server. Nutzer können diese Informationen dann über eine Anwendung auf ihrem Rechner auslesen lassen – den ersten Browser namens WorldWideWeb.

Im März 1989 stellt Berners-Lee sein Konzept erstmals vor. Ende 1990 ist der Prototyp des WWW betriebsbereit. Im Labor des Physikers läuft der erste Webserver, darauf klebt ein handgeschriebener Zettel: „Dieses Gerät ist ein Server. Nicht ausschalten!!“ Auf dem Server hat Berners-Lee eine erste Website konstruiert, die den CERN-Forschern als Austauschplattform dient und zudem das Prinzip des World Wide Web erklärt.

© dpaIn der Europäischen Organisation für Kernforschung, dem CERN, soll eigentlich nur der Austausch besser laufen – daraus entsteht das WWW.

NCSA Mosaic: Der Browser breitet sich aus

1990 beginnt mit der Abschaltung des ARPANETs auch die kommerzielle Phase des Internets: Der erste gewerbliche Internetprovider World geht an den Start. Ab sofort kann offiziell jeder mit einem Rechner und einem Modem ins Netz. Und auch die ersten Maschinen gehen online. Den Anfang macht der Toaster von John Romkey, der sich via Internet an- und ausschalten lässt. Im folgenden Jahr wird im lokalen Netz des Rechnerlabors der britischen Universität Cambridge die erste Webcam in Betrieb genommen. Sie zeigt den Füllstand der Kaffeemaschine vor dem sogenannten Trojan Room und soll den Studenten so vergebliche Wege zur Koffeinquelle ersparen.

Im Browser, wie ihn Berners-Lee programmiert hat, lässt sich die Kaffeemaschine allerdings nur über ein Zusatzprogramm auf dem Rechner betrachten. Denn Berners-Lees Webbrowser WorldWideWeb kann Grafiken nur in einem separaten Fenster anzeigen. Das ändert sich im Januar 1993 mit dem NCSA Mosaic. Der grafikfähige Browser mit der rotierenden Weltkugel im Logo verbreitet sich rasant und öffnet bald Menschen überall auf dem Globus das erste Mal das Fenster zum Internet; er wird zur Blaupause für den ersten kommerziellen Browser Netscape und bildet später die Code-Basis für den Internet Explorer. Im April 1993 übergibt das CERN die WWW-Technologie offiziell in die Gemeinfreiheit. Dadurch wird sichergestellt, dass jeder dieses System kostenfrei nutzen und weiterentwickeln darf – die Basis für die grundsätzlich offene Struktur des World Wide Web. Tim Berners-Lee wechselt 1994 vom CERN zum MIT und gründet dort das World Wide Web Consortium (W3C), das von nun an über die Entwicklung des WWW wacht.

Das Netz wird durchsuchbar

Mit der Ausbreitung des Webs wächst auch die Zahl der Webseiten und damit das Bedürfnis, Ordnung in den Informationswust zu bringen. Suchmaschinen schießen bald wie Pilze aus dem Boden: 1994 starten Lycos und Yahoo, 1995 folgt AltaVista, 1996 geht mit dem Vorläufer von Fireball der erste Browser aus Deutschland ins Netz. Zwei Jahre später kommt dann eine Suchmaschine namens Google aus der Betaphase. Eigentlich ist der Suchmaschinenmarkt bereits von diversen Anbietern besetzt, trotzdem erfreut sich der Nachzügler bald großer Beliebtheit. Denn anders als bei vielen Mitbewerbern zeigt sich die Oberfläche der Suchmaschine recht aufgeräumt und übersichtlich. Vor allem spuckt sie ausgesprochen schnell überdurchschnittlich gute Ergebnisse aus.

1998 kommt eine Suchmaschine namens Google aus der Betaphase.

Neben dem Inhalt einer Webseite bezieht Google nämlich auch deren Popularität in das Ranking der Suchergebnisse ein, indem die Zahl und die Qualität der Verlinkungen zu einer Seite ermittelt werden. Die Logik dahinter: Je öfter Menschen auf eine Webseite verlinken, desto relevanter ist sie für sie – und damit auch für andere Nutzer, die sich für ähnliche Inhalte interessieren. Das reduziert die Zahl an obskuren Treffern, mit denen etwa die Konkurrenz zu kämpfen hat.

Digitale Infektionen: Der Brain-Virus

Immer mehr User können im Internet bald immer mehr Webseiten, Angebote und Informationen aufstöbern – und dabei auch von Menschen und Programmen gefunden werden, mit denen sie lieber nicht in Kontakt gekommen wären. Bereits 1986 macht mit Brain der erste Computervirus die Runde. Weil das Schadprogramm den Bootsektor von Disketten befällt, die seinerzeit bevorzugt auf Schulhöfen ihre „Besitzer“ wechseln, verbreitet es sich bald auf der ganzen Welt.

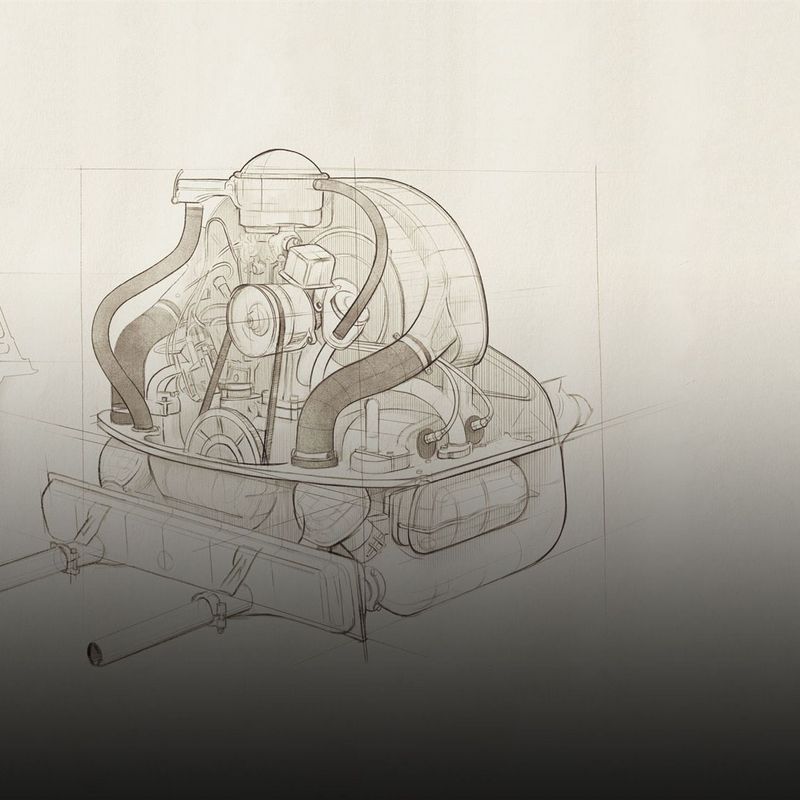

Die globale Vernetzung des Internets eröffnet dann noch einmal ganz neue Möglichkeiten, um innerhalb kürzester Zeit eine riesige Zahl von Nutzern mit den eigenen Viren und Würmern zu erreichen. Gerade Letztere sind besonders gefährlich: Während Viren sich in die Software einnisten und erst dann infektiös werden, wenn das Wirtsprogramm gestartet wird, werden die Würmer von allein aktiv. Sie versuchen selbstständig, sich über E-Mail-Programme oder Lücken in anderen Netzwerkdiensten automatisch zu verbreiten. Aus diesem Grund können sie besonders schnell viral gehen, wie schon der erste Computerwurm der Geschichte beweist.

Der Morris-Wurm und seine Folgen

Das kleine Computerprogramm, das der US-amerikanische Informatikstudent Robert Tappan Morris am 2. November 1988 schreibt, soll eigentlich nur zählen, wie viele Computer ans Internet angeschlossen sind. Aufgrund eines Programmierfehlers belässt es das Programm allerdings nicht dabei, sich einmalig von einem Computer auf einen anderen zu kopieren. Stattdessen kopiert es sich in Endlosschleife immer wieder und infiziert mindestens 6.000 Rechner, manche sprechen gar von 60.000 Computern.

Zum ersten Mal in der Geschichte des Cybercrime wendet die US-Justiz den zwei Jahre zuvor erlassenen „Computer Fraud and Abuse Act“ an. Morris, der unfreiwillige Malware-Coder, wird zu drei Jahren auf Bewährung, 10.050 Dollar Geldstrafe und 400 Stunden gemeinnützige Arbeit verurteilt. Als Reaktion auf seinen Wurm wird aus den Mitteln des US-Verteidigungsministeriums noch im November 1988 an der Carnegie Mellon University das weltweit erste Computer Emergency Response Team (CERT) gebildet. Die CERTs beschäftigen sich seitdem auch vorbeugend mit Fragen und Problemen der Computersicherheit.

Von der Stabsstelle für IT-Sicherheit zu TÜViT

Wie man sensible Daten schützen kann, das beschäftigt Mitte der 1980er-Jahre auch die IT-Spezialisten des RWTÜV in Essen. 1985 beginnen die EDV-Experten damit, ein Netzwerk zur dezentralen Datenverarbeitung einzurichten, an das außerdem das Medizinisch-Psychologische Institut (MPI) angeschlossen werden soll. Das Problem: Diese besonders vertraulichen Informationen werden gemeinsam mit anderen Daten aus dem Unternehmen auf demselben Kabel übertragen. Die Computerfachleute entwickeln daher eine technische Lösung, um die Sicherheit der Daten zu gewährleisten. Mit dieser Erfahrung im Rücken kümmern sie sich in den kommenden Jahren auch um die Datensicherheit anderer Firmen.

Ab 1989 nimmt die neu gegründete Stabsstelle für IT-Sicherheit des RWTÜV die IT-Systeme des Deutschen Zentrums für Luft- und Raumfahrt (DLR), des Dortmunder Stahlriesen Hoesch und der Vereinigten Elektrizitätswerke Westfalen (VEW) unter die Lupe. 1991 entsteht dann das Institut für Informationstechnik (IfT), das sich um die Sicherheit von Software und von elektronischen Systemen wie Herzschrittmachern kümmert. Im folgenden Jahr wird auch die Stabsstelle für IT-Sicherheit an das IfT angegliedert, das ab 1995 unter dem Namen TÜV Informationstechnik (TÜViT) firmiert.

„Gute Hacker“ im Prüflabor

In Deutschland berät TÜViT etwa Mannesmann zu modernen Autobahnmautsystemen und die Telekom zu Sicherheitsfragen bei Netzwerkmanagementsystemen. Auch internationale Tech-Riesen wie Microsoft, IBM oder Toshiba bitten die Sicherheitsexperten aus Essen um Rat. Die wiederum fuchsen sich auch bald in die Untersuchung von Chipkarten ein, die mit Telefon-, Kredit- oder Krankenkassenkarten Einzug in die Brieftaschen finden.

In ihren Software- und Hardwarelaboren attackieren die Spezialisten die Chips mit Laserstrahlen, Elektrospulen und in Kältevkammern, um herauszufinden, ob der Speicher unter Manipulation Informationen preisgibt, die er eigentlich für sich behalten sollte. Als gute Hacker nehmen sie außerdem die IT-Systeme von Unternehmen und den Betreibern kritischer Infrastrukturen ins digitale Kreuzfeuer. 2012 simulieren die Fachleute etwa einen Angriff auf die IT-Systeme des Verteilnetzbetreibers Rhein-Main-Neckar (VNB). Mit solchen Penetrationstests sollen mögliche Sicherheitslücken in der IT-Infrastruktur aufgespürt und geschlossen werden, bevor die bösen Hacker oder ihre Computerwürmer hindurchschlüpfen können. Ab 2014 führen die Experten zusätzlich Securitychecks für Smartphone-Apps durch.

Die haben 2007 mit dem Erscheinen des ersten iPhones ihren Siegeszug begonnen. In Kombination mit immer schnelleren und günstigeren Datenverbindungen explodiert auch die Zahl der Nutzer und Geräte im Netz: Besaßen 2009 in Deutschland rund sechs Millionen Menschen ein Smartphone, sind es drei Jahre später schon 31 Millionen. Ende 2018 sind 57 Millionen Deutsche mobil mit dem Internet verbunden, aktuellen Studien zufolge ist weltweit mittlerweile jeder dritte Mensch online unterwegs.

Sicherheit für die vollvernetzte Zukunft

Längst sind wir Menschen nicht mehr alleine im Netz, der Internet-Toaster von John Romkey hat zahllose Nachkommen: Weltweit stehen heute zum Beispiel rund 120 Millionen smarte Lautsprecher in den Wohnzimmern. Mit der heraufziehenden Ära des Internets der Dinge sollen immer mehr Maschinen, Fahrzeuge oder Haushaltsgeräte dauerhaft online sein, um unser Leben bequemer und Produktionsprozesse einfacher, schneller und effizienter zu machen. Verheißungsvolle Aussichten – allerdings auch für Cyberkriminelle. Schließlich vervielfältigt sich mit der Zahl der Geräte potenziell auch die Zahl der Sicherheitslücken, die von den Hackern ausgenutzt werden können.

Das Rezept der Sicherheitsspezialisten vom TÜV, um die digitale Gefährdung einzudämmen, hört auf den Namen Security by Design. Die Idee dahinter: Sicherheitsanforderungen an Soft- und Hardware schon während der Entwicklung umfassend zu berücksichtigen, um mögliche Sicherheitslücken von vorneherein zu verhindern. Ein Prinzip, das die Experten in der Praxis bei den sogenannten Smart Meter Gateways umsetzen. Die Kommunikationseinheiten übermitteln die Daten intelligenter Stromzähler an die Energieversorger und sollen im Smart Grid der Zukunft eine Schlüsselrolle einnehmen. Die TÜV-Experten unterstützen die Behörden und die Bundesregierung dabei, die Sicherheitsanforderungen an die Smart Meter Gateways zu definieren. Zugleich prüfen sie die konkreten Geräte auf Herz und Platine, damit die Daten der Verbraucher hackergeschützt das Haus verlassen – und die vollvernetzte Zukunft so sicher wie möglich ausfällt.

Nichts mehr verpassen: Jetzt kostenlosen #explore-Newsletter abonnieren

Entdeckt, erklärt, erzählt - Der Podcast

In unserem 2-wöchigen Podcast befassen wir uns auch mit Themen rund um Vernetzung und IT-Sicherheit. Über Sicherheit im Internet der Dinge sprechen wir im Interview mit Isabel Skierka. Jetzt reinhören in Teil 1 und Teil 2.